Spis treści

- 1 Firma AMD (Advanced Micro Devices) to amerykańskie przedsiębiorstwo produkujące elektronikę (głównie układy scalone) dla użytkowników domowych i firm. Do głównych produktów firmy należą karty graficzne, mikroprocesory, chipsety do płyt głównych, systemy wbudowane oraz procesory graficzne dla serwerów, stacji roboczych i komputerów PC.

- 2 Karty graficzne AMD

- 3 Jak wybrać kartę graficzną? Wybierz kartę graficzną w 5 krokach:

- 4 Karta graficzna AMD i NVIDIA – Bitwa procesorów strumieniowych

- 5 Czy w ogóle potrzebujesz osobnej karty graficznej?

- 6 Krok 1: Spójrz najpierw na procesor graficzny, a potem na markę

- 7 Krok 2: Porównaj typy pamięci, szybkości zegara i szybkość transmisji bitów

- 8 Krok 3: Zwróć uwagę na liczbę rdzeni CUDA (NVidia) i Shader (AMD)

- 9 Krok 4: Poszukaj niższych wartości TDP

- 10 Krok 5: Sprawdź kompatybilność i porty na karcie

- 11 Zgodność z procesorem i GPU

- 12 Dokonanie wyboru

Firma AMD (Advanced Micro Devices) to amerykańskie przedsiębiorstwo produkujące elektronikę (głównie układy scalone) dla użytkowników domowych i firm. Do głównych produktów firmy należą karty graficzne, mikroprocesory, chipsety do płyt głównych, systemy wbudowane oraz procesory graficzne dla serwerów, stacji roboczych i komputerów PC.

Karty graficzne AMD

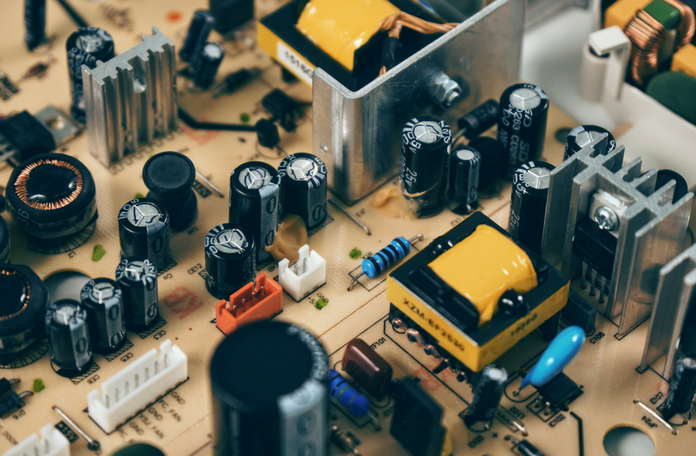

Ważną częścią wydajności każdego komputera jest procesor graficzny (lub GPU, „mózg” karty graficznej). Procesor graficzny jest szczególnie ważny w grach. GPU odpowiada za przetwarzanie danych wizualnych widocznych na monitorze. Wiele procesorów ma zintegrowane układy GPU, ale są one znacznie mniej wydajne niż procesory graficzne w dedykowanych kartach graficznych. Do gier koniecznie potrzebujemy karty graficznej.

Istnieją trzy główne wytwórnie układów GPU: AMD, Intel i NVIDIA. Intel ma zdecydowanie największy udział w rynku (ponad 60%), ale procesory graficzne Intela są zintegrowane i nie są wystarczająco wydajne, aby grać na komuterze płynnie. Do gier potrzebujesz karty AMD lub NVIDIA.

Zarówno AMD, jak i NVIDIA tworzą karty graficzne od lat i nieustannie przesuwają granice technologii GPU. Chociaż obie marki mają swoje wady i zalety, w tym artykule postaramy się wykazać podstawowe różnice, pomiędzy działaniem układu GPU, co będzie przydatne przed podjęciem decyzji, który z nich jest najlepszy dla właśnie twojego systemu.

Jak wcześniej wspomnieliśmy, GPU jest odpowiedzialny za przetwarzanie wszystkich danych wizualnych, które widzisz na monitorze. GPU musi zdecydować, jak wykorzystać każdy z 2 milionów pikseli na typowym monitorze, aby stworzyć obraz. Czyni to za pomocą danych geometrii, tekstury i oświetlenia, aby uzyskać wartości kolorów dla każdego piksela, wyświetlając obraz 2D lub 3D. W typowych warunkach dobra karta wideo może zrobić to 60 razy na sekundę!

Jeśli chodzi o porównywanie kart wideo, trudno powiedzieć, kto jest wyraźnym zwycięzcą. Zarówno AMD, jak i NVIDIA mają na uwadze ten sam cel końcowy: Zapewniają płynną i szybką jakość obrazu. Jednak każda firma stosuje inne podejście do osiągnięcia tego celu.

Karta graficzna ewoluowała od renderowania grafiki na ekranie do posiadania potężnego procesora pokładowego..

Jak wybrać kartę graficzną? Wybierz kartę graficzną w 5 krokach:

Istnieje wiele technologii, które tworzą wspaniałą kartę graficzną i orientowanie się, jak to wszystko działa, pomoże ci wybrać idealną kartę dopasowaną idealnie do twoich potrzeb.

Producenci tacy jak ASUS, Gigabyte i EVGA produkują własną markę karty graficznej. Różnią się one od siebie typem pamięci, szybkością i przepustowością, a także używanymi radiatorami.

Wszystkie te karty są zasilane przez procesory graficzne NVidia lub AMD. GPU odpowiada za wszystkie obliczenia matematyczne potrzebne do renderowania obrazów wyświetlanych na ekranie i jest tym, co napędza Twoją grafikę.

Karta graficzna AMD i NVIDIA – Bitwa procesorów strumieniowych

W przeciwieństwie do procesorów, które zazwyczaj mają od 1 do 8 rdzeni, procesory graficzne są wyposażone w wiele mniejszych rdzeni zwanych “procesorami strumieniowymi”. Podczas gdy każdy z tych procesorów strumieniowych nie ma prawie tak dużej mocy obliczeniowej, jak rdzeń procesora, współpracują one ze sobą przetwarzanie danych wizualnych o wiele bardziej wydajnie, co pozwala znacznie poprawić wydajność graficzną.

Nie wszystkie procesory strumieniowe są podobne. NVIDIA stosuje podejście polegające na tworzeniu mniejszej liczby wydajniejszych procesorów strumieniowych, pozwalając na nieco bardziej złożone obliczenia. Dzięki temu karty NVIDIA są doskonałe nie tylko w grach, ale także w wielu innych aplikacjach do przetwarzania danych , takich jak złożone systemy finansowe i informatyczne.

AMD stosuje inne podejście, tworząc mniejsze, mniej złożone procesory strumieniowe. Chociaż procesory nie są tak wydajne, różnica polega na ilości. Ponieważ mają dużo mniejszych procesorów, które obsługują proste obliczenia, szczególnie wyróżniają się w takich zadaniach, które wymagaj a przeprowadzenia wielu prostych obliczeń.

Jeśli chodzi o wybór między tymi dwoma, musisz odpowiedzieć sobie na pytanie, jaki jest twój główny cel wykorzystania karty graficznej, czyli czego od niej oczekujesz. W przypadku wykorzystania karty graficznej do gier obie firmy często wymieniają korony na najlepsze osiągi GPU i często oferują karty, które działają podobnie w kilku punktach cenowych. Najlepiej przeczytać opinie o każdej karcie, którą planujesz kupić. AMD poradzi sobie lepiej z niektórymi grami i monitorami o bardzo wysokiej rozdzielczości. NVIDIA będzie działać lepiej z innymi grami. Podobnie w przypadku zadań innych niż gry, sprawdź testy porównawcze, aby zobaczyć, który z nich jest lepszy. Różnice w architekturze GPU mogą mieć znaczący wpływ na wydajność. Wiele aplikacji obsługuje tylko określone architektury, ograniczając wybory do jednej marki lub nawet do jednej linii kart w ramach tej marki.

Jeśli planujesz gry, istnieje mnóstwo zasobów i testów porównawczych, które będą porównywać karty NVIDIA i AMD w rzeczywistych sytuacjach gier słownych, takich jak ławka Anandtech . Benchmarki dla konkretnej gry są idealne, jeśli nie są dostępne, sprawdź benchmarki dla różnych gier z podobną grafiką. Aby uzyskać dobry przegląd skuteczności kart w grach, sprawdź tę hierarchię GPU w grach.

Czy w ogóle potrzebujesz osobnej karty graficznej?

Procesor, który posiadasz, może już zawierać procesor graficzny (w jednym układzie). Intel nazywa to zintegrowaną grafiką, natomiast AMD APU (Accelerated Processing Unit). Są one wystarczające do ogólnego korzystania z komputera (maile, arkusze kalkulacyjne, dokumenty, a nawet filmy HD).

Poniżej prezentujemy poradnik, na co krok po kroku zwrócić uwagę przy wyborze karty graficznej.

Krok 1: Spójrz najpierw na procesor graficzny, a potem na markę

Obecna seria NVIDII dla serii GeForce 700 i 900 oraz AMD Radeon R7 i Radeon R9 to dobry punkt wyjścia do wyboru procesora graficznego. Wyższe numery modeli, takie jak GT 720 i GTX 950 (NVidia) lub 360 i 390 (AMD), wskazują nowsze procesory graficzne.

Seria Radeon R7 i Radeon R9 firmy AMD oraz karty GeForce 700 i 900 firmy NVidia rozpoczynają poszukiwania kart graficznych. Zwróć także uwagę na szybkość zegara GPU.

Krok 2: Porównaj typy pamięci, szybkości zegara i szybkość transmisji bitów

Dane gotowe do przetworzenia przez GPU są przechowywane we własnych, dedykowanych układach pamięci, zwanych GDDR3 i GDDR5. Układy te pracują z wyższymi prędkościami zegara w porównaniu do zwykłej pamięci stacjonarnej.

GDDR5 jest nowszy i szybszy niż GDDR3, ponieważ jest w stanie przenieść więcej danych z większą prędkością na GPU. Dane mogą być przesyłane 4 razy na cykl zegara, więc aby numery wyglądały na większe, zegar listy producenta prosi o 4x rzeczywistą prędkość zegara.

Na przykład karta graficzna, której będę używał w tej kompilacji, karta 2GB EVGA NVidia GT 740 jest wymieniona jako mająca prędkość zegara pamięci 5000 MHz (czasami wymieniona jako efektywna prędkość zegara). Rzeczywista częstotliwość taktowania wynosi 1250 MHz (5000 MHz / 4), bez względu na wartość użyć do porównania kart graficznych upewnij się, że używasz tej samej wartości.

Więcej pamięci jest dobre, ale większa przepustowość jest lepsza. Przepustowość to ilość danych, do których GPU może uzyskać dostęp na magistrali pamięci i jest wymieniona jako przepływność pamięci na karcie graficznej. Standardowe stawki to 64-bitowe i 128-bitowe, ale wyższe karty końcowe mają znacznie wyższe szybkości transmisji.

Podsumowując, ilość pamięci na karcie jest ważna, ale także spójrz na typ (GDDR3 lub GDDR5), rzeczywistą prędkość zegara pamięci i szybkość transmisji pamięci (szerokość pasma – im wyższa tym lepiej)

Krok 3: Zwróć uwagę na liczbę rdzeni CUDA (NVidia) i Shader (AMD)

GPU musi opracować sposób cieniowania obiektów 3D na ekranie, aby pokazać, jak wpływa na nie światło, aby wyglądał jak najbardziej realistycznie. Chociaż NVidia i AMD mają różne nazwy dla tych technologii, to zasadniczo mają te same skomplikowane zadania przetwarzania.

Im więcej rdzeni CUDA lub shaderów, tym lepiej GPU renderuje wspaniałe obrazy, jest to szczególnie ważne w grach, w których liczba klatek na sekundę (FPS) jest ważna lub aplikacje o dużej intensywności grafiki.

Krok 4: Poszukaj niższych wartości TDP

Podobnie jak procesor, GPU wytwarza ciepło ze wszystkich procesów, które wykonuje, co jest sygnalizowane wartością TDP. Te wartości mówią nam o mocy potrzebnej do utrzymania GPU w dopuszczalnej temperaturze, więc logicznie, im więcej mocy potrzeba, tym więcej ciepła wytwarza GPU.

Szukaj niskich wartości TDP, aby zmniejszyć zapotrzebowanie na systemy chłodzenia i wentylatory. Chłodzenie jest bardziej kosztowne, ale także głośniejsze.

Krok 5: Sprawdź kompatybilność i porty na karcie

Gniazda kart graficznych w gniazdach PCI Express (PCIe) na płycie głównej, które komunikują się z magistralą płyty głównej (kanałami danych) z różnymi prędkościami w zależności od wersji gniazda (2.0 lub 3.0) i szerokości gniazda (x8, x16 lub więcej ).

Upewnij się, że jedno z tych gniazd jest dostępne na płycie głównej i idealnie obsługuje maksymalną wersję i szerokość karty PCIe.

Należy również upewnić się, że w zasilaczu znajduje się zapasowe i prawidłowe złącze zasilania karty graficznej (zwykle 8 lub 4-pinowe złącze zasilania). Podwójne sprawdzenie wymiarów karty, aby upewnić się, że pasuje do obudowy komputera, pozwoli także uniknąć błędnie zamówionych kart.

Wreszcie sprawdź porty (HDMI i DVI) na samej karcie, obsługiwane rozdzielczości i ile monitorów może być podłączonych w tym samym czasie.

Zgodność z procesorem i GPU

Biorąc pod uwagę zgodność systemu, jedno z najczęściej zadawanych pytań brzmi: “Czy karta AMD/NVIDIA może działać z procesorem Intel/AMD?” Na szczęście nie ma znaczenia, jaki masz procesor. Karta graficzna AMD będzie działać dobrze z procesorami Intel i AMD, a karta NVIDIA zrobi po prostu to samo.

Istnieje jednak kilka uwag dla tych, którzy planują wykorzystać technologię Crossfire firmy AMD lub funkcje SLI firmy NVIDIA. Crossfire i SLI pozwalają na użycie więcej niż jednego procesora graficznego w tym samym czasie, co często dramatycznie zwiększa wydajność wideo w grach, które mogą wykorzystywać SLI lub Crossfire. W takich grach dodanie drugiej karty może dać w dowolnym miejscu od 70 do 90 procent lepszą wydajność. Bądź jednak ostrożny, jeśli gra, w którą grasz, nie obsługuje SLI ani Crossfire, ponieważ nie otrzymasz żadnych korzyści z drugiej karty.

Jedna uwaga na temat AMD: chociaż karty AMD i NVIDIA są kompatybilne z dowolnym procesorem, niektóre karty graficzne AMD z wyższej półki mogą współpracować ze zintegrowanymi procesorami graficznymi AMD w Crossfire, zapewniając nieco lepszą wydajność graficzną. Aby uzyskać więcej informacji, zapoznaj się z tym przewodnikiem dotyczącym porównywania procesorów AMD. Jeśli używasz części AMD o budżecie, warto się nimi zająć.

Dla tych, którzy chcą korzystać z podwójnej konfiguracji GPU, ważne jest, aby sprawdzić, czy płyta główna obsługuje Crossfire (dla kart dual AMD) lub SLI (dla podwójnych kart NVIDIA). Pamiętaj, że aby korzystać z SLI, musisz mieć dwie identyczne karty NVIDIA. W Crossfire możesz używać dwóch różnych kart AMD, o ile należą one do tej samej rodziny. Na przykład można używać Crossfire z HD 7970 i HD 7950. Zawsze dobrze jest zbadać problemy ze zgodnością przed dokonaniem zakupu.

Na koniec upewnij się, że twój procesor jest wystarczająco silny, aby nadążyć za kartą graficzną. Bardzo słaby procesor nie pozwoli, aby wysokiej klasy procesor graficzny osiągnął najwyższy potencjał. Jest to tzw. wąskie gardło. Ale nawet procesor średniej klasy powinien być na tyle potężny, by pozwolić najwyższej klasy procesorowi graficznemu, jak najlepiej wykorzystać jego możliwości.

Dokonanie wyboru

W końcu oba systemy AMD i NVIDIA zapewniają rozwiązania GPU, które będą działały dobrze w praktycznie każdym systemie. Dokładne planowanie i badania są zawsze kluczowe. Niezależnie od tego, czy planujesz zbudować potęgę gier, profesjonalną stację roboczą do edycji czy system obliczeniowy, poznanie opcji GPU pomoże Ci wybrać odpowiednią kartę wideo.

Obrazy, które widzisz na monitorze, są zrobione z małych kropek zwanych pikselami. W większości typowych ustawień rozdzielczości ekran wyświetla ponad milion pikseli, a komputer musi zdecydować, co zrobić z każdym, aby stworzyć obraz. Aby to zrobić, potrzebuje translatora – czegoś do pobrania danych binarnych z procesora i przekształcenia go w obraz, który widzisz. Jeśli na płycie głównej nie ma wbudowanej możliwości graficznej , tłumaczenie to odbywa się na

Pomyśl o komputerze jako firmie z własnym działem artystycznym. Kiedy ludzie w firmie chcą dzieła sztuki, wysyłają zapytanie do działu sztuki. Dział sztuki decyduje, jak stworzyć obraz, a następnie umieszcza go na papierze. Końcowym rezultatem jest to, że czyjś pomysł staje się rzeczywistym, widzialnym obrazem.

Karta graficzna działa na tych samych zasadach. CPU, pracując w połączeniu z aplikacjami, wysyła informacje o obrazie do karty graficznej. Karta graficzna decyduje, jak korzystać z pikseli na ekranie, aby utworzyć obraz. Następnie przesyła tę informację do monitora za pomocą kabla.

Tworzenie obrazu z danych binarnych jest wymagającym procesem. Aby utworzyć obraz trójwymiarowy , karta graficzna najpierw tworzy ramkę z linii prostej. Następnie rasteryzuje obraz (wypełnia pozostałe piksele). Dodaje także oświetlenie , teksturę i kolor. W przypadku szybkich gier komputer musi przejść przez ten proces około sześćdziesięciu razy na sekundę. Bez karty graficznej do wykonywania niezbędnych obliczeń obciążenie byłoby zbyt duże, aby komputer mógł sobie z nim poradzić.

Karta graficzna realizuje to zadanie za pomocą czterech głównych komponentów:

- Połączenie płyty głównej dla danych i zasilania

- Procesor decyduje, co zrobić z każdego piksela na ekranie

- Pamięć do przechowywania informacji o każdym pikselu i do tymczasowego zapisywania zakończonych zdjęć

- Połączenie monitora, dzięki czemu można zobaczyć końcowy wynik

Rzadko zdarza się, że nowoczesne GPU po prostu nie będzie grało w żadną z najnowszych gier, to czysta kwestia rozdzielczości i ustawień graficznych. Jeśli grasz w najnowsze gry AAA w High settings w Full HD, zazwyczaj chcesz wydać co najmniej 250 £, aby uzyskać doskonałą wydajność. Ale możesz wydać mniej, a oprogramowanie twojej karty graficznej (AMD Crimson lub Nvidia GeForce Experience) dostraja twoje gry, aby zapewnić ich płynność.

Częścią decyzji będzie również niestandardowy projekt chłodnicy. Popularne nazwy marek to EVGA, Asus, Gigabyte, MSI, XFX, Zotac i wiele innych. Razem otrzymujesz kombinowaną nazwę zawierającą nazwę marki , numer części karty graficznej i fajniejszy projekt . Na przykład: Asus ROG Strix GTX 1080 Gaming , Zotac GTX 1080 Amp Extreme , XFX Radeon RX 480 GTR Black Edition.

Ponieważ ceny stale się zmieniają, a oferty specjalne pojawiają się codziennie, rekomendowanie konkretnego modelu wyłącznie w oparciu o jego cenę jest trudne, więc ten przewodnik będzie oferował zwykłą ofertę cenową każdej karty i tego rodzaju wydajność, jakiej można się spodziewać.

Chłodniejsze projekty producenta również wpłyną na wydajność, ale tylko o jednocyfrowy procent punktów procentowych – dotyczy to w szczególności tańszych kart. Z droższymi kartami graficznymi producenci kart wypychają łódź, rzucając sprytne wentylatory i oprogramowanie do miksu i oferując wyższe prędkości zegara, co może mieć znaczenie.

Na co warto zwrócić uwagę na każdej karcie (w kolejności ważności):

- Długość gwarancji

- Cena

- Hałas wentylatora

- Efekt wizualny

- Dodatkowe wentylatory chłodzące

Jest jeszcze jedna rzecz do rozważenia, a mianowicie: AMD RX Vega . Karty AMD o szczytowej specyfikacji dotarły bardzo późno na „arenę” i starają się obniżyć konkurencję Nvidii pod względem cenowym, jednocześnie oferując wydajność w grach 1440p i 4K.